بناء الجملة:

نظرًا لأننا على دراية بـ ChatGPT ، فإننا نعلم أن هذه المنصة مملوكة لمجتمع Open AI وتوفر الأدوات والبنى وواجهات برمجة التطبيقات والعديد من الأطر التي يمكننا استخدامها في نشر تطبيقاتنا ونماذج معالجة اللغة الطبيعية. تقدم Open AI واجهات برمجة التطبيقات التي يمكننا من خلالها استخدام أي نماذج مدربة مسبقًا من AI و NLP من منصة Open AI ويمكن أن تجعلها تعمل لتطبيقاتنا مثل ، على سبيل المثال ، تقديم تنبؤات حول البيانات في الوقت الفعلي. وبالمثل ، توفر GPT4All أيضًا لمستخدميها إمكانية دمج نماذج الذكاء الاصطناعي المدربة مسبقًا مع التطبيقات المختلفة.

يتم تدريب نموذج GPT4All على بيانات محدودة مقارنة بـ ChatGPT. يحتوي أيضًا على بعض قيود الأداء الخاصة به مقارنةً بـ ChatGPT ولكنه يسمح للمستخدم باستخدام GPT الخاص به على أجهزته المحلية ولا يتطلب أي اتصالات بالشبكة. بمساعدة هذه المقالة ، سنتعرف على كيفية استخدام نماذج GPT4All في نص Python نظرًا لأن GPT4All لديه الارتباطات الرسمية مع Python مما يعني أنه يمكننا استخدام نماذج GPT4All ودمجها من خلال برنامج Python النصي أيضًا.

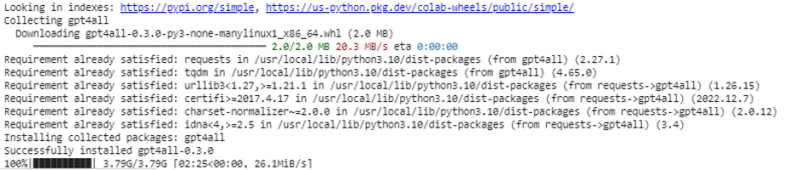

يتطلب الأمر أمرًا عبر الإنترنت لتثبيت GPT4All لـ Python IDE. بعد ذلك ، قد نقوم بدمج العديد من نماذج الذكاء الاصطناعي مثل تطبيقاتنا. يظهر الأمر لتثبيت GPT4All في Python كما يلي:

تثبيت $ pip gpt4all

مثال 1:

للبدء بهذا المثال ، نحتاج إلى تنزيل Python وتثبيتها في أنظمتنا. الإصدارات الموصى بها من Python هي 'الإصدار 3.7' أو تلك التي جاءت بعد هذا الإصدار. هناك طريقة أخرى للعمل مع Python لتجنب العملية الطويلة لتثبيت 'إعداد Python' على أنظمتنا وهي استخدام 'Google Colab' وهي بيئة قائمة على السحابة لـ Python. يمكننا تشغيل هذه البيئة على أي متصفح ويب ويمكننا بناء نماذج الذكاء الاصطناعي والتعلم الآلي. يتم تنفيذ الأمثلة التي سننفذها هنا في Google Colab.

يغطي هذا المثال طريقة تثبيت GPT4All في Python وكيفية استخدام النماذج المدربة مسبقًا. نبدأ أولاً بتثبيت GPT4All. لذلك ، يتم تنفيذ الأمر الذي ذكرناه سابقًا. مع تنفيذ الأمر ، يتم تنزيل وتثبيت GPT4All جنبًا إلى جنب مع الحزم والأطر الخاصة به.

الآن ، نحن نمضي قدما. من GPT4All ، نقوم باستيراد 'GPT4All'. هذا يضيف جميع النماذج المدربة مسبقًا من GPT4All إلى المشروع. الآن ، قد نستخدم أي نموذج منفرد ونجعله يقوم بالتنبؤات لتطبيقنا. بمجرد استيراد حزمة GPT4All ، حان الوقت الآن لاستدعاء هذه الوظيفة واستخدام نموذج GPT4All الذي يعطي مخرجات 'إكمال الدردشة'.

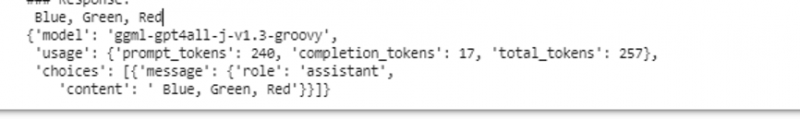

بمعنى آخر ، إذا طلبنا أي شيء من هذا النموذج في الإدخال ، فإنه يعيده في الإخراج. النموذج الذي نستخدمه هنا هو 'ggml-gpt4all-j-v1.3-groovy'. هذه النماذج مخزنة بالفعل في ذاكرة التخزين المؤقت GPT4All. يمكننا الحصول على هذه النماذج من هذا الرابط ' https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat 'للتنزيل اليدوي. إذا كان النموذج موجودًا بالفعل في ذاكرة التخزين المؤقت GPT4All ، فإننا ببساطة نسمي اسم النموذج ونحدده كمعلمات إدخال لوظيفة 'GPT4All ()'. إذا قمنا بتنزيله يدويًا بنجاح ، فإننا نمرر المسار إلى المجلد حيث يوجد النموذج. نظرًا لأن هذا النموذج مخصص لإكمال الرسالة ، يتم تقديم بناء الجملة لهذا النموذج على النحو التالي:

$ Chat_completion (رسائل)الرسائل عبارة عن قائمة قاموس ويجب أن يحتوي كل قاموس على مفتاح 'دور' بقيمة المستخدم أو النظام أو المساعد ، والمحتوى 'المفتاح' الذي له قيمة السلسلة. في هذا المثال ، نحدد المحتوى على أنه 'اسم ثلاثة ألوان' ومفتاح الدور على أنه 'مستخدم'.

نموذج $ = GPT4All ('ggml-gpt4all-j-v1.3-groovy')رسائل $ = [{'role': 'user'، 'content': 'Name 3 flowers'}]

بعد هذه المواصفات ، نسمي وظيفة 'chat_completion ()' مع النموذج. يتم عرض الكود الخاص بذلك في الإخراج التالي:

$! pip تثبيت gpt4allمن gpt4all استيراد GPT4All

model = GPT4All ('ggml-gpt4all-j-v1.3-groovy')

Messages = [{'role': 'user'، 'content': 'حدد ثلاثة ألوان'}]

model.chat_completion (رسائل)

بعد تنفيذ هذا المثال ، يُرجع النموذج ثلاثة ألوان كاستجابة للإدخال.

المثال الثاني:

نغطي مثالًا آخر حيث اكتشفنا طريقة أخرى لاستخدام GPT4All في Python. يمكن القيام بذلك باستخدام الارتباطات الرسمية لـ Python التي يتم توفيرها بواسطة 'Nomic' وهو مجتمع AI مفتوح المصدر ، ويقوم بتشغيل GPT4All. باستخدام الأمر التالي ، نقوم بدمج 'nomic' في وحدة تحكم Python الخاصة بنا:

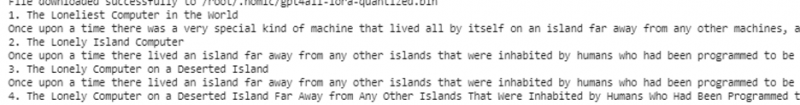

تثبيت nomic $بمجرد تثبيت هذا ، نقوم باستيراد GPT4All من 'nomic.gpt4all'. بعد استيراد GPT4All ، نقوم بتهيئة GPT4All بوظيفة 'open ()'. بعد ذلك ، نسمي الوظيفة 'المطالبة ()' ونمرر المطالبة بهذه الوظيفة. بعد ذلك ، يتم إنشاء استجابة سريعة بناءً على الموجه الذي قدمناه كمدخل للنموذج الفوري.

! نقطة تثبيت nomicمن nomic.gpt4all استيراد GPT4All

# تهيئة نموذج GPT4All

بدء = GPT4All ()

initiate.open ()

# توليد استجابة بناءً على الموجه

model_response = initiate.prompt ('اكتب قصة قصيرة عن الكمبيوتر)

# تبديد الاستجابة المتولدة

طباعة (نموذج_استجابة)

يعرض الإخراج الاستجابة السريعة من النموذج الذي أنشأناه باستخدام نموذج GPT4All المدرب مسبقًا في Python. إذا أردنا معرفة المزيد عن النماذج وكيف يمكننا استخدام هذه النماذج لتوليد الردود ، أو بكلمات بسيطة ، إذا أردنا اكتساب المعرفة حول بناء الجملة لتوليد الاستجابات من هذه النماذج ، فقد نأخذ المزيد من المساعدة من GPT4 جميع تفاصيل التوثيق الفني.

خاتمة

لا تزال GPT4All تسعى جاهدة للحصول على دقة الأداء. يتم تشغيله بواسطة نظام AI الأساسي الذي يهدف إلى توفير روبوتات محادثة ذكية اصطناعيًا لمستخدميها على وحدات المعالجة المركزية (CPU) على مستوى المستهلك نظرًا لأن GPT4All يعمل بدون أي اتصال بالشبكة ووحدات معالجة الرسومات. تنيرنا هذه المقالة لاستخدام PyGPT4All بكفاءة في بيئة Python وإنشاء تفاعل بين تطبيقاتنا ونماذج GPT4All AI المدربة مسبقًا. لقد قمنا بتغطية طريقتين مختلفتين حول كيفية تثبيت GPT4All في Python في هذا الدليل.